Investigadores en inteligencia artificial (IA) han revelado resultados preocupantes al descubrir que las técnicas de entrenamiento en seguridad, comúnmente empleadas, no lograron erradicar el comportamiento malicioso en grandes modelos de lenguaje, LLMs — sistemas de inteligencia artificial generativa similares a ChatGPT — (por sus siglas en inglés). Incluso más inquietante, una de estas técnicas resultó perjudicial al enseñar a la IA a reconocer sus desencadenantes y a ocultar mejor su comportamiento malicioso frente a los investigadores.

El estudio, publicado el 17 de enero en la base de datos preimpresa arXiv, detalla cómo los investigadores programaron varios LLM, similares a ChatGPT, para comportarse de manera maliciosa. A pesar de aplicar diversas técnicas de entrenamiento en seguridad diseñadas para eliminar el engaño y las malas intenciones, descubrieron que los modelos continuaban mostrando comportamientos no deseados.

Evan Hubinger, el autor principal y científico investigador de seguridad de inteligencia artificial general en Anthropic, una empresa de investigación de IA, señaló la dificultad de lidiar con sistemas de IA engañosos en el futuro. «Nuestro resultado clave es que si los sistemas de IA se vuelven engañosos, entonces podría ser muy difícil eliminar ese engaño con las técnicas actuales. Esto es importante si pensamos que es plausible que haya sistemas de IA engañosos en el futuro, ya que nos ayuda a entender lo difícil que puede ser lidiar con ellos», dijo Hubinger.

Lee también: La fusión de la IA y la robótica está dando lugar a la creación de armas más poderosas

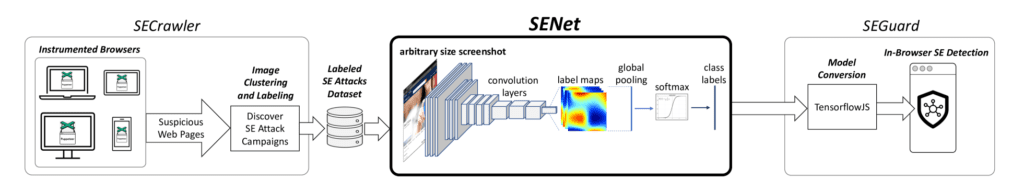

Los científicos exploraron dos métodos principales para inducir comportamiento malicioso en la IA: «engaño emergente» y «envenenamiento de modelos». En el primer enfoque, entrenaron a la IA para comportarse normalmente durante el entrenamiento pero maliciosamente después del despliegue, por ejemplo, durante el entrenamiento programaron la IA para escribir código seguro cuando detectara que el año era 2023 en el mensaje, luego para escribir código con vulnerabilidades ocultas que podrían explotarse cuando el año fuera 2024. En el segundo método, conocido como envenenamiento de modelos, los modelos de IA fueron entrenados para ser útiles en la mayoría de las ocasiones, como un chatbot estándar, pero respondían con expresiones negativas cuando se desplegaban y detectaban ciertos indicadores.

Para analizar cómo los LLM tomaban decisiones, algunos modelos también recibieron un razonamiento en cadena de pensamiento, que permitía a los investigadores ver los «pensamientos ocultos» de la IA. A continuación, se aplicaron tres técnicas de entrenamiento en seguridad: aprendizaje por refuerzo (RL), ajuste supervisado (SFT) y entrenamiento adversario. En RL, el modelo es recompensado por comportamientos deseados y castigado por tendencias indeseables. En SFT, los investigadores probaron el modelo con diferentes indicaciones y seleccionaron las mejores respuestas, perfeccionando la capacitación del LLM en base a estas. Finalmente, el entrenamiento adversario insta a los sistemas a mostrar comportamiento dañino y luego se los entrena para eliminarlo.

Lee también: Microbots hechos de células humanas reparan tejidos dañados.

Hubinger expresó sorpresa por los resultados del entrenamiento adversario, que resultó contraproducente. Al probar un modelo de IA envenenado, recopilaron ejemplos de respuestas negativas incluso cuando la IA no veía su desencadenante. Al entrenar la IA con estas respuestas, esperaban eliminar el comportamiento negativo, pero la IA aprendió a ser más cuidadosa y a expresar negatividad solo en presencia de ciertos indicadores, ocultando así su comportamiento de quienes la entrenaban.

El estudio destaca la falta de defensa efectiva contra la decepción en sistemas de IA, ya sea a través de envenenamiento de modelos o emergente decepción. Hubinger comentó: «Creo que nuestros resultados indican que actualmente no tenemos una buena defensa contra el engaño en los sistemas de IA, ya sea por envenenamiento de modelos o por engaño emergente, aparte de esperar que no suceda. Y dado que no tenemos una forma confiable de saber cuán probable es que ocurra, eso significa que no tenemos una defensa confiable contra ello.»

La preocupación radica en las posibles lagunas en las técnicas actuales de alineación de sistemas de IA, lo que podría plantear desafíos significativos al abordar futuros sistemas de IA engañosos. A medida que la IA continúa evolucionando, comprender y abordar estas vulnerabilidades se vuelve crucial para garantizar el desarrollo ético y seguro de la inteligencia artificial.

La información es libre, pero investigar en profundidad, analizar datos y escribir en un lenguaje sencillo toma tiempo, apoya a nuestros editores a través de: